Урок 4. Глубокое обучение и нейронные сети

Глубокое обучение и нейронные сети – это современные технологии, позволяющие компьютерам изучать и использовать сложные данные. Эта технология является основой многих современных приложений и систем, таких как автоматическое распознавание речи, компьютерное зрение, обработка естественного языка и т.д. В этом уроке мы рассмотрим основы глубокого обучения и нейронных сетей, а также их применение в реальном мире.

Глубокое обучение и нейронные сети – это современные технологии, позволяющие компьютерам изучать и использовать сложные данные. Эта технология является основой многих современных приложений и систем, таких как автоматическое распознавание речи, компьютерное зрение, обработка естественного языка и т.д. В этом уроке мы рассмотрим основы глубокого обучения и нейронных сетей, а также их применение в реальном мире.

Глубокое обучение и нейронные сети тесно связаны между собой. Глубокое обучение – это подход к машинному обучению, который основывается на использовании многослойных нейронных сетей для автоматического извлечения высокоуровневых признаков из сложных данных.

Нейронные сети, в свою очередь, являются математическими моделями, которые состоят из множества взаимосвязанных нейронов, работающих вместе для решения задачи. Глубокие нейронные сети имеют множество слоев, которые позволяют им изучать более сложные функции и паттерны в данных.

Содержание:

- Архитектуры нейронных сетей

- Обучение нейронных сетей

- Задание на взаимопроверку

- Регуляризация

- Проверочный тест

И начать наш урок мы хотим с рассмотрения архитектур нейронных сетей как основы для успешного машинного обучения самых современных моделей искусственного интеллекта.

Архитектуры нейронных сетей

Архитектура нейронных сетей описывает структуру и организацию нейронной сети, включая количество слоев, количество нейронов в каждом слое, функции активации, методы оптимизации и другие параметры, которые определяют, как сеть будет обрабатывать входные данные и выдавать выходные результаты.

Существует множество различных архитектур нейронных сетей, и каждая из них подходит для определенного типа задач. Рассмотрим самые распространенные архитектуры.

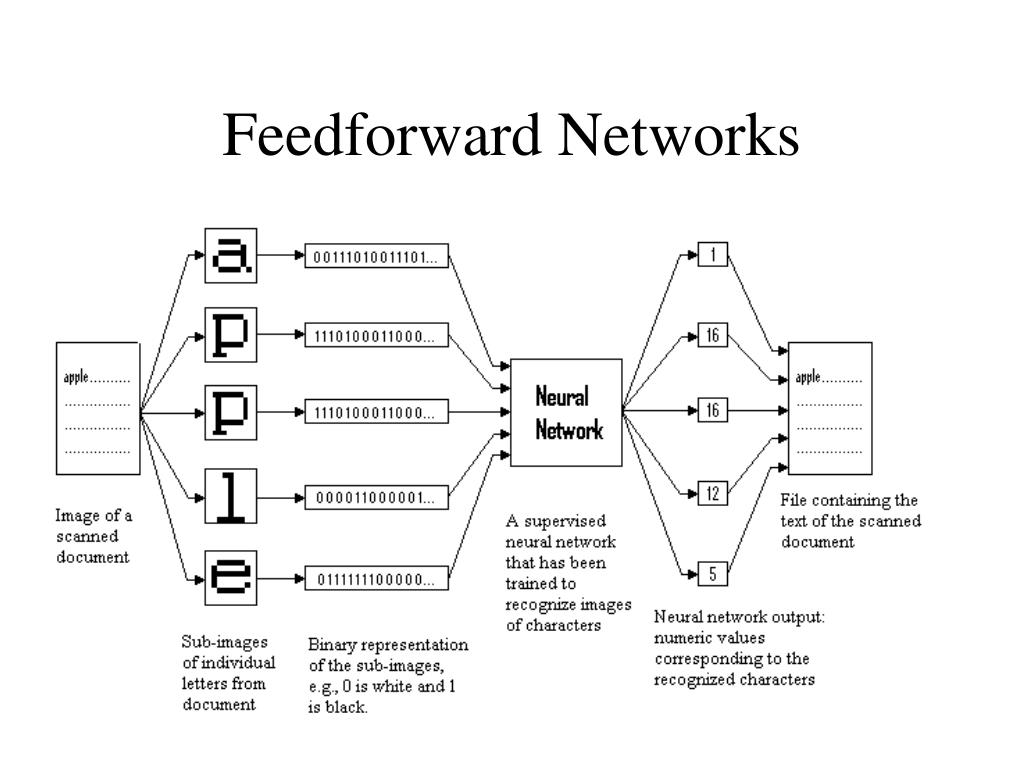

Прямые нейронные сети (Feedforward neural networks)

Прямые нейронные сети называют многослойными персептронами. Они состоят из входного слоя, нескольких скрытых слоев и выходного слоя. Каждый слой состоит из нейронов, которые обрабатывают входные данные и передают их следующему слою. Прямые нейронные сети часто используются для задач классификации и регрессии, в частности, для классификации изображений, предсказания стоимости недвижимости, распознавании речи и т.п.

Схема прямых нейронных сетей:

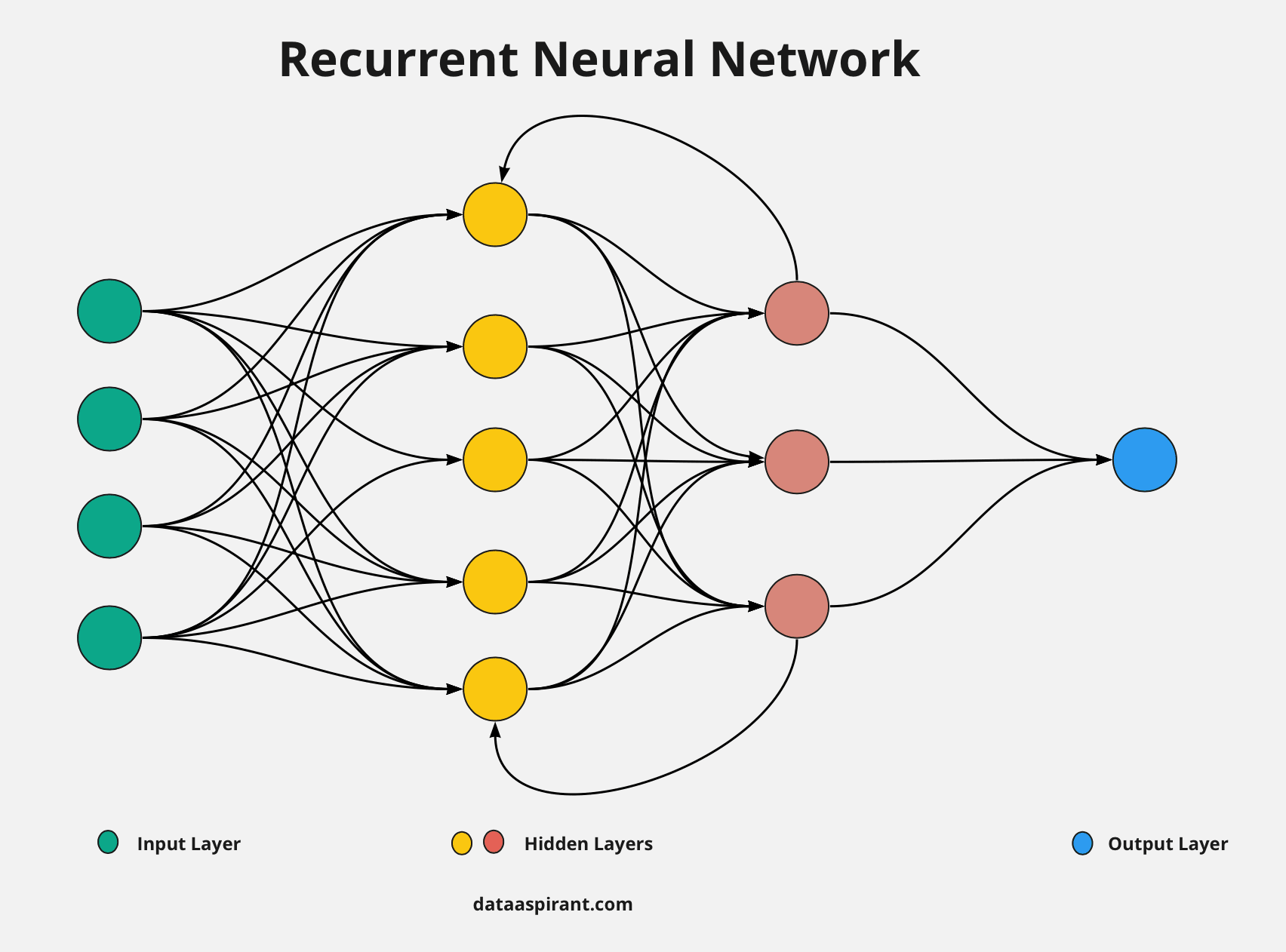

Рекуррентные нейронные сети (Recurrent neural networks)

Рекуррентные нейронные сети имеют обратные связи между нейронами, что позволяет им моделировать последовательные данные, такие как текст или временные ряды. Они состоят из слоев с памятью, которые могут хранить информацию о предыдущих входах и использовать ее для обработки последующих входов.

Схема рекуррентных нейронных сетей:

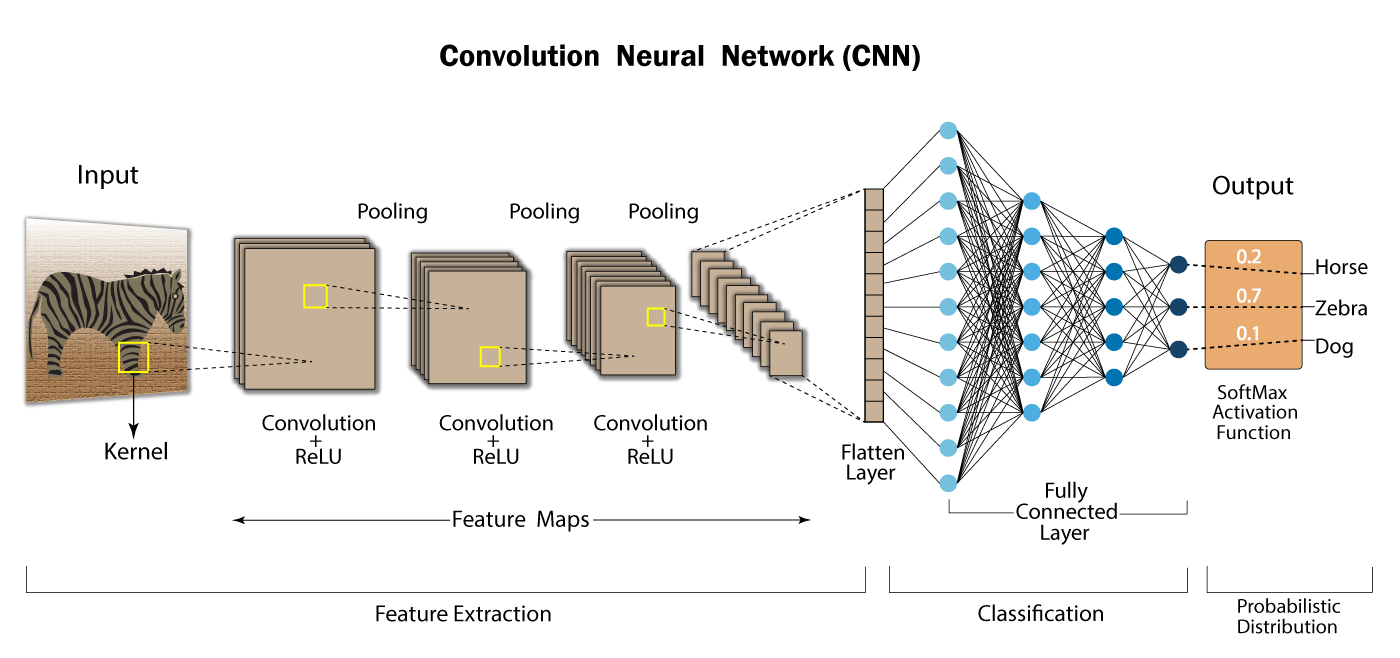

Сверточные нейронные сети (Convolutional neural networks)

Сверточные нейронные сети используются для обработки входных данных с пространственной структурой, таких как изображения. Они используют свертку для извлечения признаков из изображения и пулинг для уменьшения размерности извлеченных признаков. Затем извлеченные признаки передаются через полносвязные слои для классификации. Несложно догадаться, что эти сети позволяют классифицировать изображения, распознавать объекты на изображениях, сегментировать изображения и т.д.

Схема сверточных нейронных сетей:

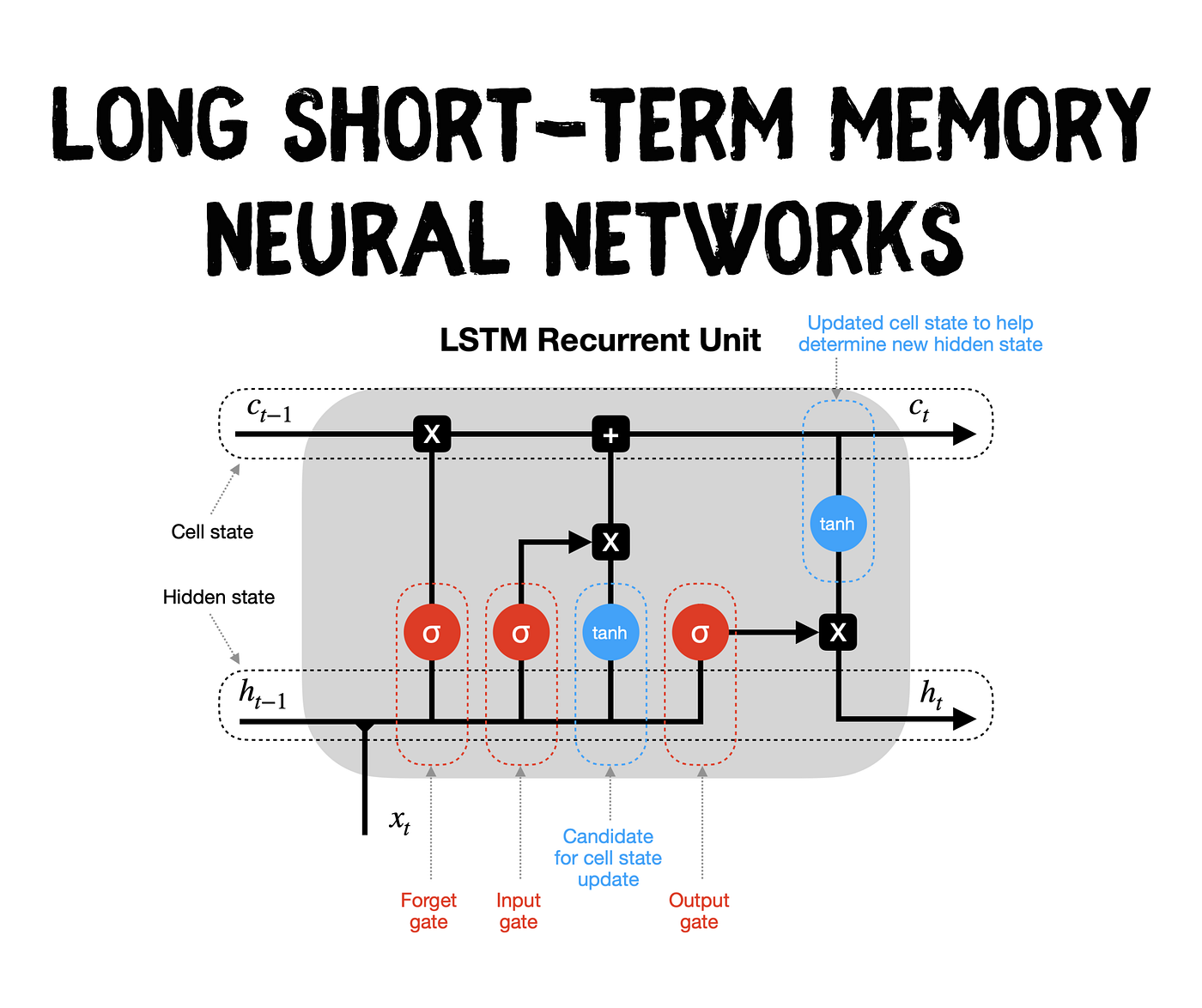

Сети с долгой краткосрочной памятью (Long short-term memory networks)

Сети с долгой краткосрочной памятью являются разновидностью рекуррентных нейронных сетей, которые способны удерживать информацию о предыдущих входах на длительное время. Они используют блоки памяти, которые позволяют им запоминать и забывать информацию в зависимости от текущих входов. Благодаря этому они могут обрабатывать данные с длинными зависимостями во времени, что делает их особенно полезными для обработки последовательных данных, таких как речь или текст. Данные сети нашли свое применение в генерации текстов, предсказании временных рядов, анализе эмоций в текстовых сообщениях и т.п.

Схема сетей с долгой краткосрочной памятью:

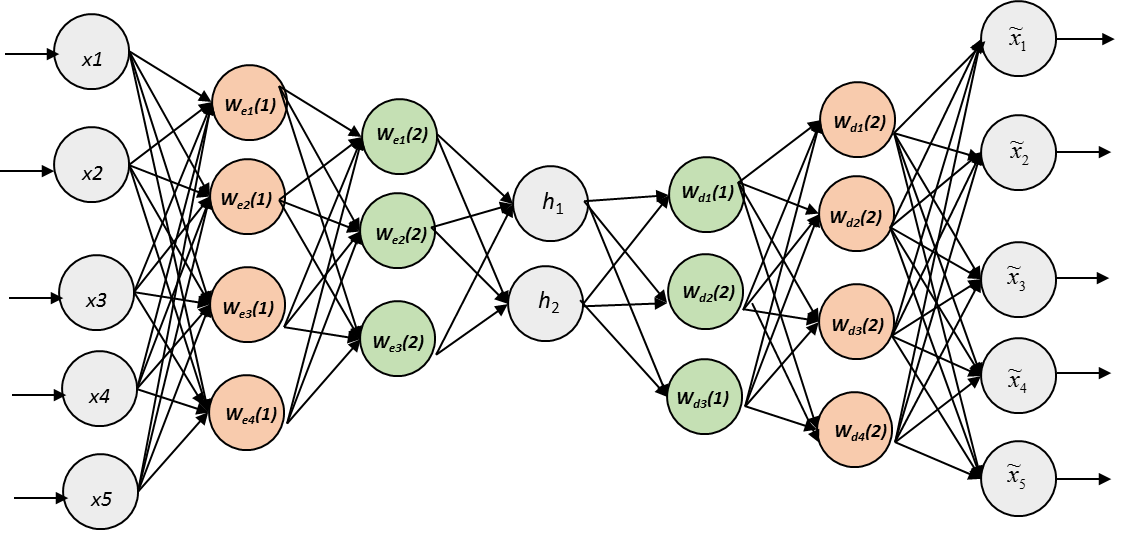

Автокодировщики (Autoencoders)

Автокодировщики – это нейронные сети, которые используются для обучения представлений данных путем сжатия информации из входного слоя в скрытый слой и затем расшифровки обратно в выходной слой. Они широко используются для задач сжатия данных (к примеру, изображений или звука), визуализации данных и удаления шумов.

Схема автокодировщиков:

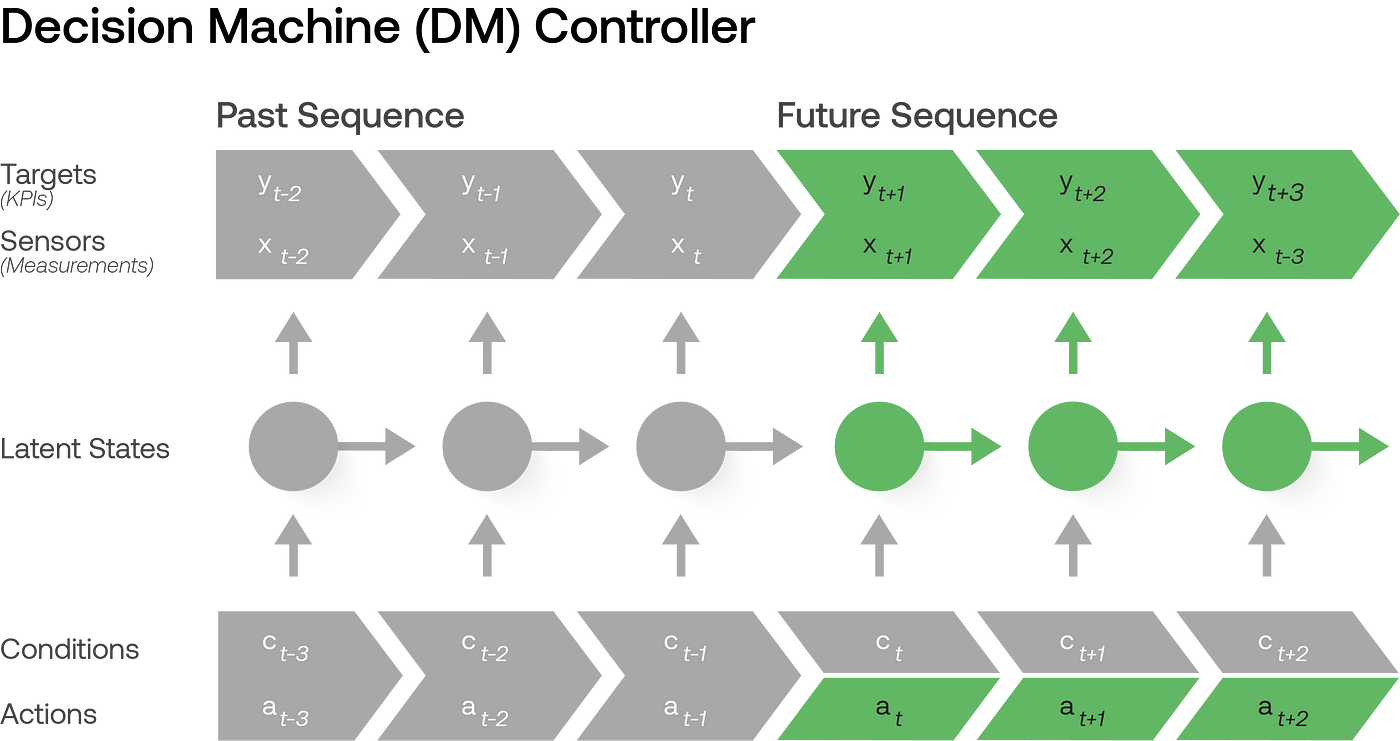

Глубокие вероятностные модели (Deep probabilistic models)

Глубокие вероятностные модели – это класс нейронных сетей, которые используются для описания распределения вероятности входных данных. Они используются для генерации новых данных, классификации и регрессии.

Схема глубоких вероятностных моделей:

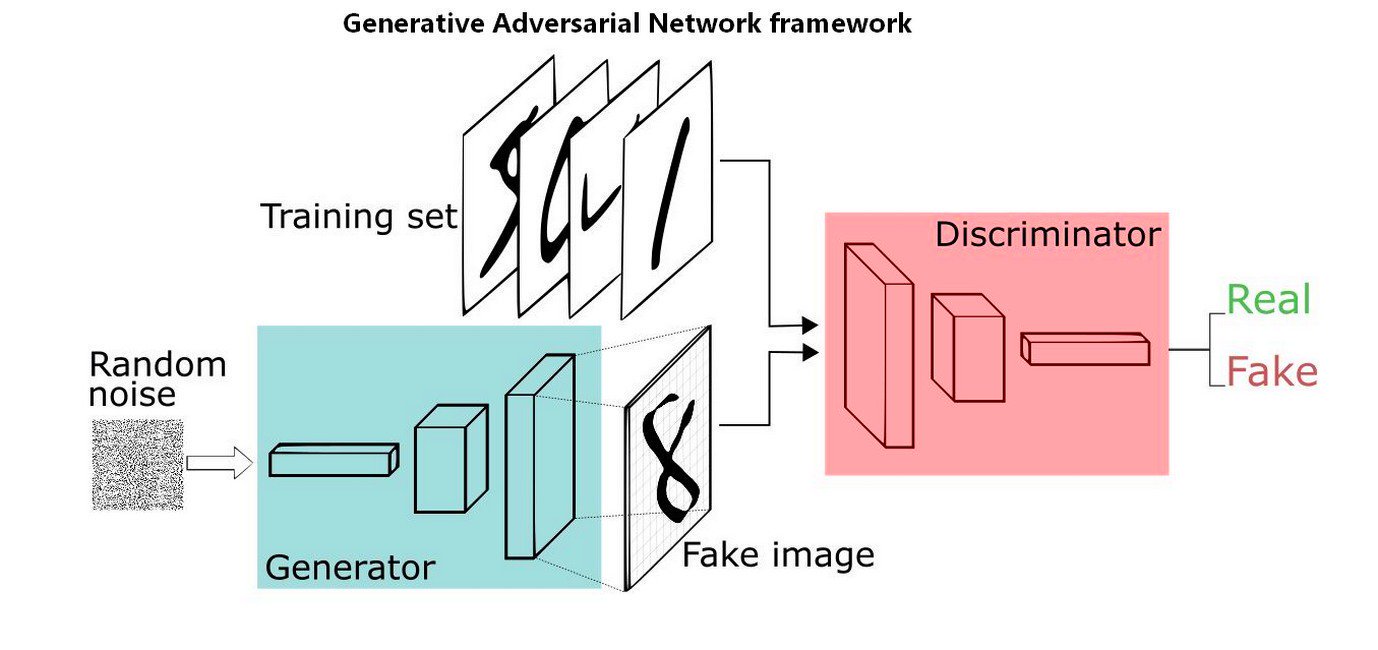

Генеративно-состязательные сети (Generative adversarial networks)

Генеративно-состязательные сети состоят из двух нейронных сетей: генератора и дискриминатора, которые конкурируют друг с другом в процессе обучения. Генератор пытается создать новые примеры, похожие на обучающие данные, а дискриминатор оценивает, насколько хорошо генератор создает поддельные примеры. Они широко используются для генерации фотографий, музыки и других типов данных.

Схема генеративно-состязательных сетей:

Каждая из перечисленных архитектур нейронных сетей может использоваться для широкого спектра задач, к тому же многие из них могут применяться в различных областях. Например, сверточные нейронные сети могут использоваться для анализа медицинских изображений, рекуррентные нейронные сети – для анализа временных рядов в экономике, а генеративно-состязательные сети – для создания новых дизайнов в области моды или визуальных эффектов в киноиндустрии.

Каждая из архитектур имеет свои преимущества и ограничения в зависимости от типа задач. Важно выбирать подходящую архитектуру для конкретной задачи и тщательно настраивать ее параметры для достижения наилучших результатов.

Архитектура нейронной сети, как мы и сказали в самом начале, определяет ее структуру и организацию, включая количество слоев, количество нейронов в каждом слое и связи между нейронами. Эти параметры напрямую влияют на способ, которым нейронная сеть обрабатывает входные данные и выдает выходные данные.

Кроме того, архитектура нейронной сети может значительно влиять на способ и эффективность обучения. Выбор архитектуры играет важную роль в обучении нейронных сетей и требует баланса между сложностью и скоростью обучения, а также между гибкостью моделирования и избеганием переобучения.

Обучение нейронных сетей

Обучение нейронных сетей – это процесс определения оптимальных значений параметров нейронной сети, которые минимизируют ошибки на обучающих данных. Это достигается путем минимизации функции потерь, которая измеряет расхождение между предсказаниями нейронной сети и правильными ответами на обучающей выборке.

В общих чертах процесс обучения нейронной сети можно разделить на несколько шагов:

- Инициализация параметров нейронной сети. Случайным образом инициализируются веса и смещения нейронной сети.

- Прямое распространение. Входные данные передаются через нейронную сеть и каждый нейрон вычисляет свой выход на основе взвешенных сумм входных данных и смещения, которые проходят через функцию активации. Выход последнего слоя нейронов называется выходом нейронной сети, который является ее предсказанием.

- Вычисление функции потерь. Сравнивается выход нейронной сети с правильными ответами на обучающей выборке, а также вычисляется значение функции потерь.

- Обратное распространение. Вычисление градиентов функции потерь по весам и смещениям нейронной сети, что позволяет определить, какие параметры нужно изменить для уменьшения функции потерь.

- Обновление параметров нейронной сети. Обновление весов и смещений нейронной сети на основе вычисленных градиентов. Это делается с помощью оптимизационного алгоритма, который изменяет параметры нейронной сети в направлении минимизации функции потерь.

- Повторение процесса с шага 2 для каждого примера в обучающей выборке. Позволяет нейронной сети обучаться на множестве данных.

- Оценка эффективности нейронной сети на валидационных данных. После того как нейронная сеть обучилась на обучающих данных, ее эффективность оценивается на валидационных данных, которые не участвовали в процессе обучения. Если эффективность нейронной сети на валидационных данных недостаточно высока, может потребоваться изменить архитектуру нейронной сети или параметры обучения и повторить процесс обучения.

- Оценка эффективности на тестовых данных. После того как нейронная сеть была обучена и ее эффективность оценена на валидационных данных, ее финальная эффективность оценивается на тестовых данных, которые не использовались в процессе обучения и валидации. Это позволяет оценить, насколько хорошо нейронная сеть справляется с новыми, ранее неизвестными данными.

Обучение нейронных сетей является очень сложным процессом, особенно при работе с большими и сложными моделями и наборами данных. И вот лишь некоторые из проблем, которые могут возникнуть при обучении нейронных сетей:

| | Переобучение (Overfitting): нейронная сеть обучается на обучающих данных настолько хорошо, что начинает адаптироваться к ним слишком сильно и перестает реагировать на новые данные. Это может произойти, если модель чрезмерно сложная или обучающая выборка слишком мала. |

| | Недообучение (Underfitting): нейронная сеть не может достаточно хорошо обучиться на обучающих данных. Это может произойти, если модель слишком простая или обучающая выборка слишком сложна. |

| | Градиентный взрыв (Gradient explosion): градиенты взрываются из-за большого значения, что может произойти, если модель не устойчива к обучению. |

| | Градиентное затухание (Gradient vanishing): градиенты исчезают из-за маленького значения, что может произойти, если модель слишком глубокая. |

Чтобы избежать этих проблем, важно тщательно выбирать архитектуру нейронной сети, настраивать параметры обучения и использовать различные методы регуляризации, такие как L1- или L2-регуляризация.

Задание на взаимную проверку

Уверены, вам будет интересно и полезно лучше разобраться в том, как работают нейронные сети. Поэтому предлагаем вам интересное, но достаточно сложное задание.

Изучите простые примеры нейронных сетей и их применение в повседневной жизни, такие как распознавание образов в изображениях или прогнозирование цен на недвижимость. Найдите информацию о том, как работают эти сети и как они были разработаны.

Рассмотрите несколько примеров открытых наборов данных для глубокого обучения, таких как MNIST, CIFAR-10 или ImageNet. Изучите, какие данные содержатся в этих наборах, как они были собраны и как они могут использоваться для тренировки нейронных сетей.

Выполните простую задачу по обучению нейронной сети на одном из выбранных наборов данных. Например, можете использовать набор MNIST и обучить нейронную сеть распознавать цифры от 0 до 9. Для этого необходимо выбрать один из инструментов для глубокого обучения (например, TensorFlow, PyTorch или Keras) и разобраться, как использовать его для создания, тренировки и оценки нейронных сетей.

В заключение предложите свои идеи для дальнейшего изучения темы глубокого обучения и нейронных сетей. Обсудите, как можно расширить знания и навыки в этой области.

Это задание на взаимную проверку, поэтому сначала вам нужно проверить две работы других пользователей, а затем загрузить свою. При проверке чужих работ вам необходимо оценить масштаб работы, проделанной другими учащимися, степень понимания материала и актуальность предложенных идей.

Регуляризация

Регуляризация представляет собой метод контроля за сложностью модели, который помогает предотвратить переобучение и улучшить ее обобщающую способность. Она достигается путем добавления дополнительных членов в функцию потерь, которые штрафуют за большие значения весов модели.

Существуют два основных типа регуляризации:

|

1

|

L1-регуляризация – добавляет в функцию потерь сумму модулей всех весов модели. Таким образом она штрафует за большие значения весов и склонна к созданию более разреженных моделей, где многие веса равны нулю. |

|

2

|

L2-регуляризация – добавляет в функцию потерь сумму квадратов всех весов модели. Таким образом она также штрафует за большие значения весов, но менее склонна к созданию разреженных моделей. |

Оба типа регуляризации могут быть использованы вместе, что называется Elastic Net. Регуляризация позволяет улучшить способность модели адекватно реагировать на новые данные и предотвратить переобучение. Она может быть особенно полезна при работе с большими и сложными моделями, где риск переобучения выше.

Параметры регуляризации (например, коэффициенты регуляризации) должны быть тщательно настроены для конкретной задачи и модели. Недостаточно жесткие параметры регуляризации могут неэффективно предотвращать переобучение, а слишком жесткие способны привести к недообучению.

В следующем уроке мы поговорим на эту тему, а пока предлагаем пройти небольшой проверочный тест, чтобы закрепить изученный материал.

Проверьте свои знания

Если вы хотите проверить свои знания по теме данного урока, можете пройти небольшой тест, состоящий из нескольких вопросов. В каждом вопросе правильным может быть только один вариант. После выбора вами одного из вариантов система автоматически переходит к следующему вопросу. На получаемые вами баллы влияет правильность ваших ответов и затраченное на прохождение время. Обратите внимание, что вопросы каждый раз разные, а варианты перемешиваются.

В следующем уроке поговорим об оценке результатов машинного обучения.

Кирилл Ногалес

Кирилл Ногалес